Inteligencia Artificial y ChatGPT

En la actualidad, cualquier discusión sobre inteligencia artificial seguramente incluirá el surgimiento de ChatGPT, el omnipresente chatbot construido sobre la serie GPT de grandes modelos de lenguaje (LLM, por sus siglas en inglés) de OpenAI. Pero, ¿cómo puede satisfacer las demandas de esta tecnología de IA generativa en su centro de datos?

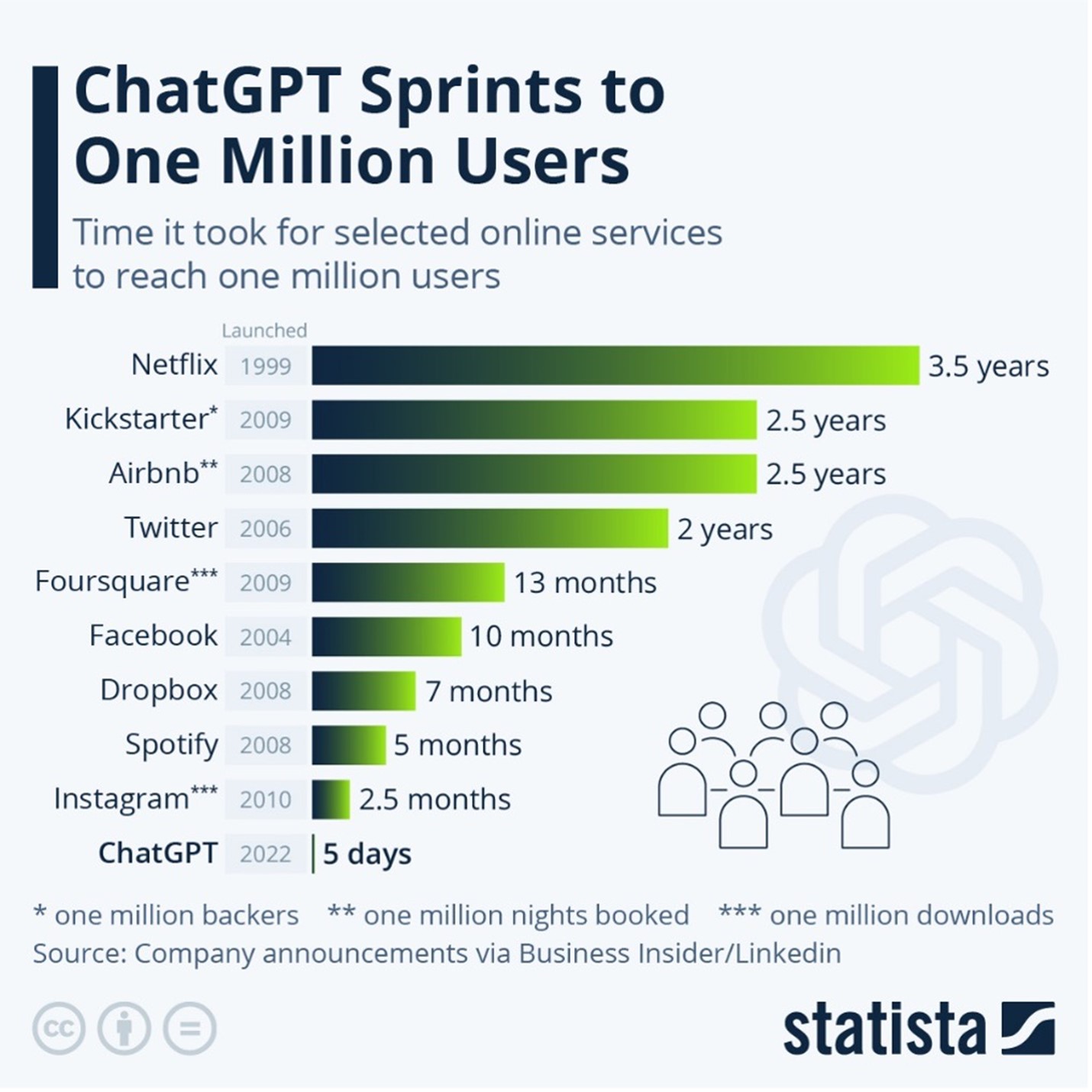

El chatbot fue lanzado a fines del año 2022 y está causando sensación con sus capacidades de generación de contenido. La gente utiliza ChatGPT y bots de otros competidores de GPT para obtener respuestas a preguntas complejas y automatizar tareas como escribir código de software y producir textos de marketing.

Pero con todas las posibilidades inherentes a esta tecnología de IA generativa, ha sido difícil utilizar modelos fundamentales en todo su potencial. La mayoría de los modelos que existen han sido entrenados con datos disponibles públicamente, lo que los hace menos que ideales para aplicaciones empresariales específicas, como consultar documentos internos confidenciales.

Construyendo grandes modelos de lenguaje: un asunto costoso dentro de los centros de datos

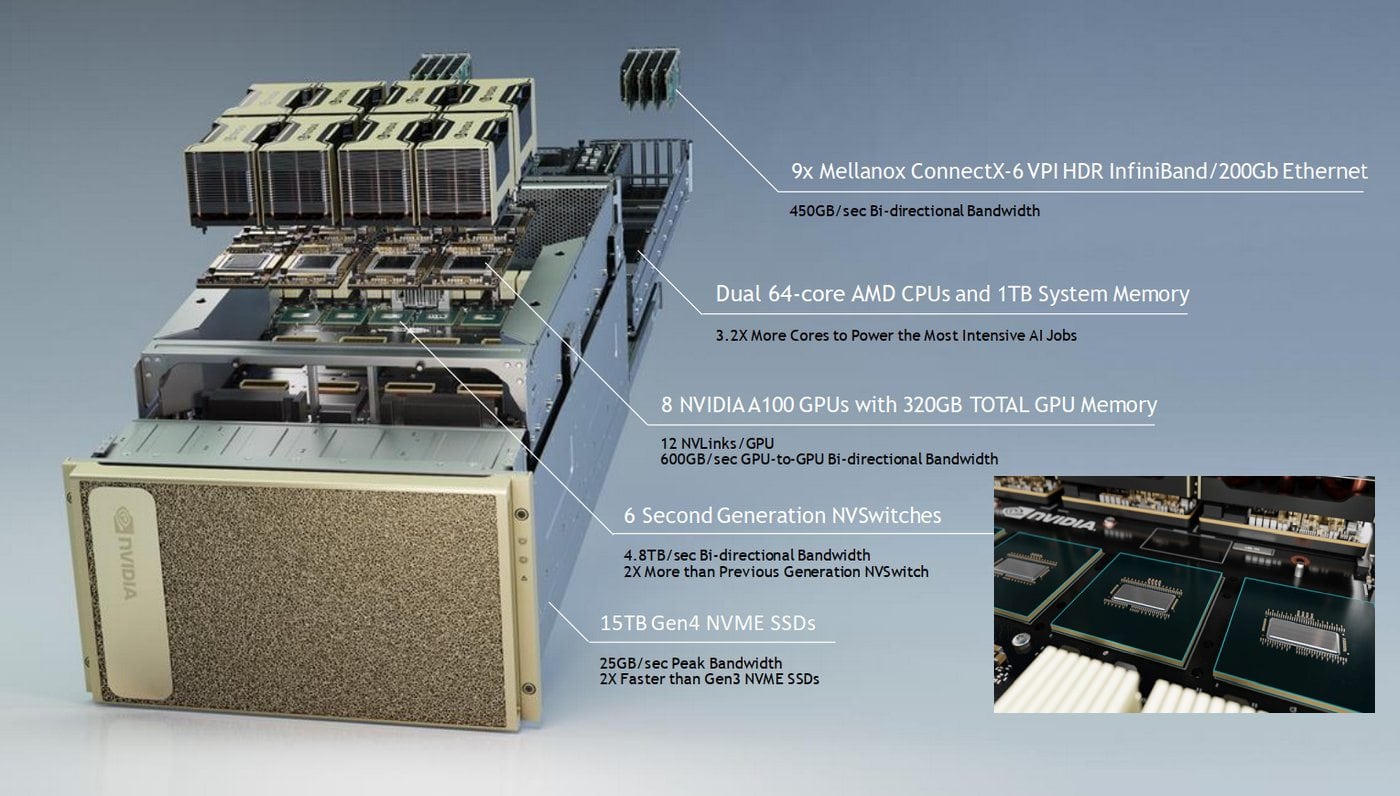

La tarea de crear un Large Language Model o LLM, como GPT-3 o GPT-4, requiere varios pasos, comenzando con una capacitación intensiva en computación que exige cientos, si no miles, de costosas GPU agrupadas en servidores de centros de datos durante varias semanas o meses.

Estos Datacenters deben de contar con certificaciones para poder albergar sistemas computacionales de avanzada, como la certificación Tier III del Uptime Institute o mayor. Hoy por hoy, DataTrust es el único datacenter comercial TIER III para El Salvador.

«La formación inicial requiere una cantidad muy importante de potencia informática. Por ejemplo, el modelo BLOOM, una alternativa de código abierto de 176 mil millones de parámetros a GPT-3, requirió 117 días de capacitación en un clúster de 384 GPU. Esto equivale aproximadamente a 120 años de GPU», – Julien Simon de Hugging Face a durante una entrevista de Venturebeat

Según Julien Simon de Hugging Face , a medida que aumenta el tamaño del modelo, aumenta la cantidad de GPU necesarias para entrenarlo y volver a entrenarlo.

Google, por ejemplo, tuvo que conectar 6,144 chips para entrenar su modelo PaLM de 540 mil millones de parámetros. El proceso también exige experiencia en técnicas y herramientas de capacitación avanzadas (como Microsoft DeepSpeed y Nvidia MegaTron-LM), que pueden no estar fácilmente disponibles en la organización.

Una vez finalizado el entrenamiento, estos chips son necesarios para realizar inferencias en el modelo de forma continua, lo que aumenta aún más el costo. Para ponerlo en perspectiva, usar solo 500 servidores multi-GPU DGX A100 de Nvidia, que se usan comúnmente para capacitación e inferencia de LLM, a $199,000 dólares cada uno significaría gastar alrededor de 100 millones de dólares en el proyecto.

Además de esto, el consumo de energía adicional y la producción térmica proveniente de los servidores aumentarán el costo total de propiedad.

Se trata de una gran inversión en infraestructura de centros de datos, especialmente para empresas que no son organizaciones dedicadas a la IA y que solo buscan LLM para acelerar ciertos casos de uso empresarial.

Bloomberg GPT: El enfoque ideal hacia un centro de datos certificado para la era de la IA

A menos que una empresa tenga conjuntos de datos únicos de alta calidad que puedan crear un modelo con una sólida ventaja competitiva que valga la pena la inversión, la mejor manera de seguir adelante es ajustar los LLM de código abierto existentes para casos de uso específicos de los propios datos de la organización, como documentos corporativos, correos electrónicos de clientes, etc.

Un buen contraejemplo es el modelo BloombergGPT, un modelo de 50 mil millones de parámetros entrenado por Bloomberg desde cero.

El ajuste, por otro lado, es un proceso mucho más ligero que requerirá solo una fracción del tiempo, presupuesto y esfuerzo. El centro Hugging Face es una firma de Inteligencia Artificial (IA) que alcanzó un valor de mercado de 4,500 millones de dólares, en cuya inversión participaron Google, Amazon, Nvidia, Salesforce, AMD, Intel, IBM y Qualcomm.

Esta valoración duplica la de la startup desde mayo de 2022 y alberga actualmente más de 250,000 modelos de código abierto para una amplia gama de tareas de procesamiento de lenguaje natural, visión por computadora y audio. Lo más probable es que encuentre uno que sea un buen punto de partida para su proyecto. Si una empresa ve valor en crear un LLM desde cero, debería comenzar poco a poco y utilizar infraestructura de nube administrada o nube DataTrust y servicios de aprendizaje automático (ML) en lugar de comprar costosas GPU para su implementación en el sitio de inmediato.

«Inicialmente, utilizamos una infraestructura MLOps alojada en la nube, lo que nos permitió dedicar más tiempo a desarrollar la tecnología en lugar de preocuparnos por el hardware. A medida que hemos crecido y la arquitectura de nuestra solución se ha asentado desde los primeros días de rápida investigación y desarrollo, ahora tiene sentido abordar el alojamiento local de los modelos», Bars Juhasz, CTO y cofundador del generador de contenido Undetectable AI.

La planificación sigue siendo clave

Antes de apresurarse a invertir en GPU, habilidades o socios en la nube para LLM de dominios específicos y aplicaciones basadas en ellos, es importante que los tomadores de decisiones técnicas definan una estrategia clara colaborando con otros líderes de la empresa y con expertos en la materia. Es útil centrarse en el argumento comercial de la decisión y tener una idea aproximada de cuáles serían las demandas actuales y futuras de dichas cargas de trabajo.

Con este tipo de planificación, las empresas pueden tomar decisiones informadas sobre cuándo y cómo invertir en la formación de un LLM. Esto incluye aspectos como qué tipo de hardware elegir, dónde pueden utilizar modelos preexistentes desarrollados por otros y quiénes podrían ser los socios adecuados en sus viajes hacia la IA.